11 Minuten

site-unspecific ist ein vierspuriges Album mit elektronischer Musik, die ursprünglich im Ambisonic-Format komponiert wurde. Es ist ein Ergebnis des künstlerischen Forschungsprojekts Embodied/Encoded: A Study of Presence in Digital Music, das von der Norwegischen Musikakademie finanziert wurde1, mit zusätzlichen Ressourcen im Zusammenhang mit Natasha Barretts Reconfiguring the Landscape-Projekt.2 Embodied/Encoded erforscht "Präsenz" aus den konzeptionellen Blickwinkeln der erweiterten Realität und der verkörperten Musikkognition sowie durch Praktiken der Aufnahme, kreativen Codierung, räumlichen Audioproduktion und elektroakustischen Musikkomposition.

Die Orte und Räume, die in den Kompositionen evoziert werden, sind nicht spezifisch, sondern tragen die klanglichen Ephemera, die die akustische Erfahrung der realen Welt charakterisieren. Die Szenen werden gefiltert und fragmentiert, so wie wir uns gegenwärtige Momente neu vorstellen, während wir ihnen begegnen, und sich in weite Räume von Geist und Körper ausdehnen.

In diesem Artikel werden die technischen Aspekte der site-unspecific-Komposition Sill Life von der Produktion in räumlichen Audioumgebungen bis hin zu ihrer letztendlichen Reduktion auf das Stereoformat erörtert. Es werden einige praktische Fragen im Zusammenhang mit Ambisonics untersucht, insbesondere der Übergang zwischen verschiedenen Studio- und Konzertkonfigurationen und die Entwicklung von Dekodierungsschemata für beide. Weitere Überlegungen gelten maßgeschneiderten Syntheseroutinen mit räumlich verteilten Klangereignissen und der Frage, wie diese im Ambisonic-Raum funktionieren, wenn sie als virtuelle Quellen kodiert werden.

FluCoMa in SuperCollider

Wie kann der flüchtige Charakter von akustischen Klängen in der realen Welt durch digitale Strukturen kreativ be- und verarbeitet werden? Wie könnte das Oszillieren zwischen akustischen und digitalen Archetypen einen prozessualen und poetischen Ansatz für die Komposition bilden? Diese Fragen liegen der kreativen Methodik von site-unspecific zugrunde, die die Rekonfiguration der realen Welt durch digitale Techniken erforscht.

Das Album ist autobiografisch und entstand überwiegend aus Feldaufnahmen von Orten in Oslo, Norwegen, während meiner Zeit als Forschungsstipendiat. Es vermittelt nomadische Metaphern und Gefühle der Einsamkeit, die ich als Immigrant nach meinem Umzug auf dem Höhepunkt der COVID-19-Pandemie im Jahr 2020 erlebte. Die konzeptionellen und technischen Aspekte der Werke sind im Forschungskatalog gut dokumentiert.3 Hier biete ich eine tiefere Analyse des Sounddesigns und der Produktionstechniken, die für das 2021 komponierte Werk Still Life entwickelt wurden.

Zu Beginn der Fellowship-Phase begann ich mit der Fluid Corpus Manipulation (FluCoMa) Suite von Externals für die Programme SuperCollider und Max zu arbeiten. FluCoMa ermöglichte den Zugriff auf verschiedene Wahrnehmungsdimensionen von aufgenommenen Klängen mit Genauigkeit und Flexibilität.4 FluCoMa enthält eine Reihe von Audio-Slicern, die verschiedene Arten von Onset-Merkmalen in einem Audiostrom identifizieren und die Daten zur Verwendung in anderen Prozessen ausgeben. Die Slicer können so konfiguriert werden, dass sie wahrnehmungsrelevante Schallereignisse nach verschiedenen Analysekriterien isolieren.

Alle Arbeiten zu site-unspecific implementierer Onset-Analyse und Slicing in irgendeiner Form, insbesondere in Form von algorithmischen Neuanordnungen von Slices, sind in SuperCollider kodiert. Die Neuanordnung kann prozedural erfolgen oder auf der Grundlage von Wahrnehmungskriterien wie Tonhöhe, Lautstärke oder Dauer (z. B. Anordnung der Slices auf der Grundlage der durchschnittlichen Tonhöhe von niedrig nach hoch). Mit dieser Methode konnte ich lange Zeitspannen von aufgezeichnetem Material behandeln und generative musikalische Prozesse hören, die durch verschiedene Analysemethoden angetrieben werden.

Für Still Life arbeitete ich mit Aufnahmen von Gesangsimprovisationen der Mezzosopranistin Marika Schultze und mit Feldaufnahmen, die in Oslo, Norwegen, und Gainesville, Florida, aufgenommen wurden. Slicer wurden mit zwei verschiedenen Methoden der Granularsynthese gekoppelt, die in SuperCollider enthalten sind: Bei der ersten Methode verwendete ich GrainBuf UGen, um Granularströme aus einer Audiodatei mit präziser Audiorate zu konstruieren, jedoch mit begrenztem Zugriff auf individuelle Grainparameter. GrainBuf wurde für die synchrone Granularsynthese verwendet, bei der die Grain-Frequenz periodisch ist und den Quellen modulierbare Formant-Spitzen aufzwingt. Wie Mikrosound-Enthusiasten wissen, spielt die Grain-Hüllkurve in diesem Fall eine wichtige Rolle bei der künstlich erzeugten Resonanzstruktur. Glatte Hüllkurven wie das Hann-Fenster wurden verwendet, um sonore Legato-Linien und scharfe, perkussive Hüllkurven für breitbandige Texturen zu erzeugen. In Beispiel 1 wurde die Tonhöhenanalyse der Gesangsquelle (in Hz) auf die Frequenz des synchronen Granularstroms abgebildet:

Beispiel 1: Still Life

Beim zweiten Ansatz verwendete ich die OffsetOut UGen, um einen Sampler mit samplegenauem Timing zu planen. Dieser Ansatz ermöglichte eine Steuerung einzelner Grains auf einer niedrigeren Ebene, mit der Möglichkeit, zeitlich variierende Hüllkurven auf die Grain-Tonhöhe anzuwenden oder einzelne Grains zu verräumlichen.

Ein Beispiel für Letzteres ist bei ca. 4:04-4:53 von Still Life zu hören. In diesem Abschnitt wurden die Quellenaufnahmen entsprechend den Veränderungen der spektralen Energie in Scheiben geschnitten. Jede Scheibe wurde in 4 gleiche Teile unterteilt, die in separaten Kanälen wiederholt wurden (insgesamt acht Kanäle für Stereoquellen). Für jeden Slice wählte ich eine Reihe von Beat-Unterteilungen, über die sich die vier Slice-Teile wiederholen sollten. Die rhythmischen Unterteilungen blieben über verschiedene Eingangsquellen hinweg konstant.

Meine Idee war es, eine Reihe von metrisch unterschiedlichen Impulsgruppen zu komponieren, die nacheinander wiederholt und mehreren Klangquellen aufgezwungen werden. Diese werden dann übereinander gelegt, wobei sich jede auf einzigartige Weise entfaltet, aber an dieselbe vorgegebene rhythmische Struktur gebunden ist. Unterschiedliche Quellen werden durch gemeinsames Verhalten miteinander verbunden.

Die separaten Audiokanäle wurden später in Ambisonics verräumlicht, indem sie sich in gleichen Teilen der horizontalen Ebene von vorne nach hinten zum Hörer bewegten. Bei perkussiven oder punktuellen Quellen werden die Attack-Anteile der Slices im vorderen Teil des Hörraums und die Release-Anteile im hinteren Teil lokalisiert, wobei zwei Interpolationsstufen vorgesehen sind.

Das Klangbeispiel (Beispiel 2) beginnt mit einer synthetischen Kick-Drum und einem in der Tonhöhe verschobenen Snare-Sound, zu dem sich schließlich eine frequenzmodulierte Stimme gesellt – alles pulsiert im Gleichklang.

Ambisonic-Werkzeuge

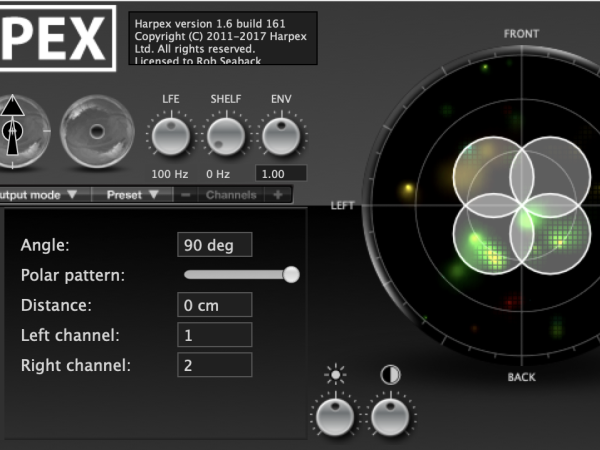

Die site-unspecific-Kompositionen wurden in Reaper mit Ambisonics-Plugins von IEM, ambiX und Harpex zusammengestellt. Harpex wurde für die Dekodierung in konventionellen Studioräumen verwendet, d. h. in Stereo-, quadrophonen, 5.1-, 7.1- und oktophonen Studios. Harpex mildert die zerstörerischen Effekte niedriger ambisonischer Ordnungen durch aktives Matrixing.5 Es war ein unschätzbares Werkzeug während der COVID-19-Ära, als viele Studioräume nicht zugänglich waren und es notwendig wurde, einen ambisonischen Workflow in meinem Heimstudio zu entwickeln.

Harpex ermöglichte auch das "Up-Sampling" der ambisonischen Auflösung von Aufnahmen, die mit dem Soundfield SPS200-Mikrofon gemacht wurden – von FOA auf 3OA. Die Verwendung des SPS200 war trotz seiner begrenzten räumlichen Auflösung eine entscheidende Lernerfahrung bei der Entwicklung einer Methodik für räumliche Audiokomposition. Die Gesangsaufnahmen für Still Life wurden mit dem Mikrofon sowohl in einem trockenen Studioraum als auch in den halligen Levinsalen der Norwegischen Musikakademie gemacht (Abbildung 1). Während die trockenen Aufnahmen in vielerlei Hinsicht nützlich waren, bot der Hall des Levinsalen einen starken Bezugspunkt für den Grad der Immersion, den ich mir von meiner Musik in Surround-Lautsprecherkonfigurationen wünschte. Nach der Dekodierung gab es keine räumlichen Lücken in der Klangprojektion, was durch den üppigen Nachhall leicht spürbar war. Dies steht im Gegensatz zu Methoden der Synthese virtueller ambisonischer Quellen aus Mono- oder Stereodateien, die eine Nachbearbeitung oder räumliche Synthesestrategien für einen ähnlichen Effekt erfordern.

In meiner kompositorischen Herangehensweise nutzte ich die vollständige räumliche Immersion von Klangfeldaufnahmen als expressiven Parameter, während ich konventionelle Aufnahmen synthetisierte, um das Bild auf einen kleineren Bereich zu verkleinern oder als Punktquellen zu zerstreuen. In Still Life handelt es sich bei den Klangfeldaufnahmen von Levinsalen um beiläufige Geräusche – subtile Vokalisen und Körperbewegungen –, die dem Werk eine geheimnisvolle räumliche Tiefe auf niedrigem dynamischen Niveau verleihen und zum tiefen Zuhören anregen.

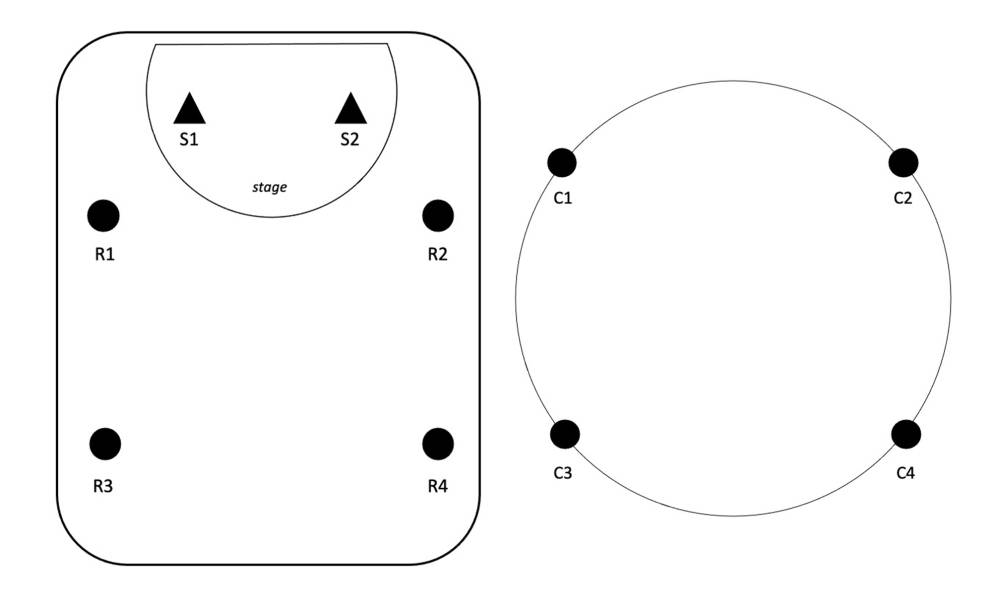

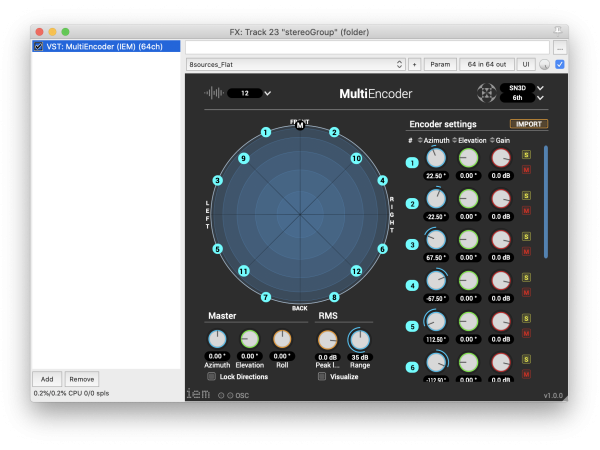

Die in SuperCollider synthetisierten Mehrkanal-Tondateien wurden als virtuelle Quellen kodiert, die in grundlegenden räumlichen Mustern angeordnet sind, wie in Abbildung 2 dargestellt. Hier sind die Quellen in Links/Rechts-Paaren gruppiert, beginnend vorne beim Hörer und gleichmäßig nach hinten verteilt. Diese Anordnung ist in gewisser Weise auch in den vorherigen Klangbeispielen zu erkennen, die für diese Präsentation in Stereo dekodiert wurden.

Abbildung 2. Virtuelle Quellenverteilung mit IEM MultiEncoder Plugin.

Surround Reverb im Still Life

Der Ansatz für den künstlichen Nachhall in Still Life war die Faltung mit einer Reihe von Surround-Impulsantworten, die von zwei Quellenpositionen aus aufgenommen wurden.6 Ich habe das Plugin mcfx_convolver aus der Multikanal-Audio-Plugin-Suite von Matthias Kronlachner verwendet, aber auch jedes andere Faltungsplugin könnte für diese Methode verwendet werden. Ich verwendete den linken Eingang des Plugins als Quelle 1 (siehe Abbildung 3), gefaltet mit den vier Empfängerkanälen, und den rechten Eingang als Quelle 2. Wenn man den Eingang (vor dem Effekt) von links nach rechts schwenkt, wird zwischen den Quellen-/Empfängersätzen der beiden Quellenpositionen überblendet.

Die vierkanalige Ausgabe wurde dann als vier virtuelle Ambisonic-Quellen kodiert, die die Mikrofonanordnung der IR-Aufnahme simulieren. Dies ermöglichte einen Hall mit höherer räumlicher Auflösung, als dies mit Impulsantworten im B-Format möglich ist. In frühen Versionen von Still Life wurde der Hall in 3OA kodiert, um die Diffusität niedrigerer Ordnungen zu nutzen, während frühe Reflexionskomponenten als eine Kette kurzer Verzögerungen simuliert wurden, die in 6OA kodiert waren.

Abbildung 3: Positionen von IR-Quelle (S) und -Empfänger (R), und gefaltete Signale (C) als virtuelle Schallquellen.

Ambisonics im Konzert

Still Life wurde am 2. Oktober 2021 bei einem selbstproduzierten Konzert an der Norwegischen Musikakademie (NMH) uraufgeführt. Kurz darauf wurde es bei der IEM in Graz im Rahmen des studentischen 3D-Audio-Produktionswettbewerbs erneut präsentiert, wo es mit dem Goldpreis in der Kategorie Computermusik ausgezeichnet wurde. Im Jahr 2022 wurde das Werk auf der Sound and Music Computing Conference in St. Étienne, Frankreich, mit 22 Lautsprechern und auf der International Computer Music Conference in Limerick, Irland, mit 16 Lautsprechern präsentiert. Zuletzt wurde es 2023 beim Ultima Contemporary Music Festival in einer 2D-Konfiguration mit 16 Lautsprechern präsentiert.

In Fällen, in denen Lautsprecherarrays mit ausreichender Dichte zur Verfügung stehen, ist das Spat5-Paket von Max Externals das bevorzugte Werkzeug für die Dekodierung gewesen. Das liegt an der allgemeinen Flexibilität des Decoders, der die Möglichkeit bietet, mit verschiedenen Decodierungsmethoden und Optimierungsstrategien zu experimentieren. Im letzteren Fall habe ich die Einstellung "In-Phase/Max-Re" als effektiv empfunden, die Optimierungsstrategien auf niedrige bzw. hohe Frequenzen bei einer benutzerdefinierten Crossover-Frequenz anwendet. Außerdem ist die Lautsprecherkalibrierung mit dem spat5.align~-Objekt, das dieselben Lautsprecherdefinitionen wie der Decoder erhält, sehr praktisch.

Die Dekodierungsphase von Ambisonics ist sicherlich die entscheidende und bei Konzerten oft die problematischste. So war es zum Beispiel schwierig, genaue Informationen über die Lautsprecherpositionen bei den oben genannten Veranstaltungen zu erhalten, und die Zeit war sehr knapp, um die Kalibrierung zu überprüfen oder mehr als eine Dekodierungsmethode zu testen. Anekdotisch betrachtet gibt es innerhalb der akademischen Disziplin des Sonic Computing Unstimmigkeiten in Bezug auf die Konzertproduktion. Der Grad der Professionalität in diesem Bereich variiert stark von Veranstaltung zu Veranstaltung, von Konferenz zu Konferenz. Ein schlecht dekodiertes Ambisonics-Stück kann im Vergleich zu kanal- oder objektbasierten Spatial-Audio-Werken "lo-fi" klingen, was sich negativ auf das Engagement des Publikums auswirkt oder den Eindruck einer schlechten Produktion vermittelt.

In Oslo konnte diese Situation gemeistert werden, da die 3DA-Audiogruppe High-Density-Lautsprecherarrays zum Verleih zur Verfügung stellte und Notam oder Electric Audio Unit regelmäßig Raumklangkonzerte veranstalteten. Bei den Künstlern und Produzenten dieser Konzerte handelt es sich in der Regel um Spezialisten mit großer Erfahrung im Bereich Spatial Audio. Für mein Konzert beim Ultima Festival 2023 habe ich Lautsprecher von NMH mit zusätzlichen Genelecs von 3DA erworben, um die Ambisonic-Order zu maximieren. Außerdem habe ich mit einem Produktionsteam vor Ort zusammengearbeitet, um die Lautsprecher aufzustellen und zu kalibrieren. Der Prozess dauerte viele Stunden und ist ein Beweis für die Notwendigkeit einer detaillierten Planung, ausreichender Aufbauzeit und qualifizierter Arbeitskräfte für Ambisonics-Konzerte.

Dekodierung in Stereo

Die Reduktion des 3D-Klangbildes auf Stereo war die letzte Herausforderung für site-unspecific-Kompositionen. Natürlich inspiriert mich das sinnliche, vollmundige Erlebnis von immersiven Audioformaten zu dieser Arbeit. Dennoch bin ich mit dem einfachen Stereohören zufrieden und freue mich darauf, das Publikum mit diesem weithin zugänglichen Medium zu erreichen.

Ich habe mit Voreinstellungen in Harpex experimentiert, die typische Stereo-Mikrofonierungstechniken für die Dekodierung simulieren. Die Blumlein-Voreinstellung, die zwei bidirektionale Mikrofone in senkrechter Anordnung simuliert, war gut geeignet, um einen Großteil des 3D-Bildes zu erfassen. Es erzeugt eine sehr breite Stereobreite ohne Lautstärkeverlust im hinteren Bereich. Allerdings funktionierte diese Voreinstellung nicht bei allen Materialien gut. Im schlimmsten Fall kam es bei breitbandigen Klängen, die sich schnell zwischen verschiedenen räumlichen Positionen bewegten, zu transienten Verschmierungen. ORTF-, NOS- und XY-Simulationen waren bei diesem Material wesentlich stabiler. In anderen Fällen wurden koinzidente und nahezu koinzidente Paare einfach zum Auffüllen des Stereoraums verwendet, um zentrierte Brennpunkte zu erzeugen, die den kommerziellen Standards der Stereoproduktion näherkommen.

Ich habe Stems entsprechend dem räumlichen Profil des Tonmaterials erstellt, die jeweils von einer anderen Stereodekodierungsvoreinstellung gerendert wurden: XY-Simulation für die schmalste Reduktion und Blumlein für die breiteste und vollständigste. Schließlich wurden die Stems zum professionellen Mastering geschickt.

Abbildung 4.1. Blumlein Stereoeinstellungen in Harpex

Abbildung 4.2. ORTF Stereoeinstellungen in Harpex

Zusammenfassung

Die Komposition von Still Life war eine technische Erkundung von Klanganalyse- und Zerlegungswerkzeugen, algorithmischen Prozessen, experimentellen Aufnahmen und Ambisonics. Ich hoffe, dass die Details der Ambisonics vom Standpunkt der künstlerischen Praxis und nicht der wissenschaftlichen Forschung aus für die Leser nützlich sein werden, insbesondere die Verhandlung zwischen immersiven Konzertsituationen und kommerziellen Hörformaten. Methoden der Klangverarbeitung und des Instrumentendesigns können dazu dienen, den kreativen Geist anzuregen – und ihre Integration in einen Ambisonics-Workflow dient als praktische Demonstration.

Die Methoden und Werkzeuge hinterlassen ihre eigenen Spuren im virtuellen Hörerlebnis, da reale Objekte und Räume von der Digitalisierung absorbiert und kreativ umgestaltet werden. Aber letztlich ist Still Life keine technische Übung. Die in diesem Artikel beschriebenen Techniken waren allesamt Mittel zum Zweck: die Manifestation eines poetischen Raums, der aus dem körperlichen und emotionalen Potenzial der vorliegenden Klänge Kapital schlägt.

- 1

Robert Seaback, "Embodied/Encoded: A Study of Presence in Digital Music", Forschungskatalog (2024). https://doi.org/10.22501/nmh-ar.1397388.

- 2

Natasha Barrett, "Reconfiguring the Landscape", Forschungskatalog (2024). https://doi.org/10.22501/rc.1724428.

- 3

Seaback, "Embodied/Encoded".

- 4

P.A. Tremblay, et al., "The Fluid Corpus Manipulation Toolbox", Zenodo (Juli 7, 2022). https://doi.org /10.5281/zenodo.6834643.

- 5

Harpex LTD, "Technologie"," https://harpex.net/ (Zugriff am 4. Mai 2022).

- 6

Ich habe diese IRs nicht selbst erstellt. Sie wurden mir von einem Kollegen zur Verfügung gestellt.

Robert Seaback

Robert Seaback ist ein US-amerikanischer Komponist und Klangkünstler, der derzeit in Florida lebt. Seine Musik ist Ausdruck des Viszeralen, des Hyperrealen, des digitalen Stillstands und der Kontinuitäten dazwischen, wobei er Stimmen, Instrumente, Klanglandschaften und synthetische Quellen durch digitale Techniken integriert. Er komponiert oder spielt in Medien wie Spatial Audio, gemischte Musik für Ensemble, elektroakustische Improvisation und Klanginstallation. Seine Musik wurde bei zahlreichen internationalen Veranstaltungen präsentiert und bei namhaften Wettbewerben mit mehreren Preisen ausgezeichnet.

Artikelthemen

Artikelübersetzungen erfolgen maschinell und redigiert.

Robert Seaback

Robert Seaback