6 Minuten

Objektbasierte Audiosysteme wie MPEG-H Audio bieten sich für den Einsatz in der Sportübertragung und insbesondere beim Fußball an. Ein Grund hierfür ist, dass Spitzensport von jeher als Innovationstreiber auf und neben dem Spielfeld fungiert. Wichtiger ist jedoch die Tatsache, dass es gerade in dieser Sportart eine Reihe unterschiedlicher akustischer Elemente gibt, die sich hervorragend eignen für die Verwendung als personalisierbare Audioobjekte.

Eine klassische Sendekette mit MPEG-H Audio Unterstützung

In Brasilien wurde der MPEG-H Standard im Dezember 2021 als einziges verpflichtendes Audiosystem für TV 3.0, die neue Generation des terrestrischen Rundfunks, ausgewählt. Dies folgte auf seine Aufnahme in TV 2.5 (eine Zwischenstufe zwischen digitalem TV 2.0 und Next Generation TV 3.0) im Jahr 2019. Seit 2021 ist MPEG-H Audio im regulären 24/7-Sendebetrieb über ISDB-T auf Sendung. Der Medienriese Globo nutzte die Fußballweltmeisterschaft 2022, um MPEG-Audio flächendeckend sowohl für TV 2.5, als auch für TV 3.0 einem Praxistest zu unterziehen. Ein UHD und HDR-Videosignal wurde gemeinsam mit 16 Audiokanälen, inklusive 5.1+4H Bett, Kommentar und weiterer Effekte, von Katar nach Brasilien übertragen. Hier begann die Aufbereitung der Signale, bei dem führende Technologien aus TV 2.5 und TV 3.0 mit MPEG-H Audio kombiniert und im Regelbetrieb verwendet wurden.

KI-gestützte Tools erleichtern die Arbeit mit komplexen Mikrofon-Setups.

Bei Globo in Rio de Janeiro wurden die Audiodaten mit dem Linear Acoustic Authoring and Monitoring System (AMS) live mit Audio-Interaktivität und Personalisierungsoptionen angereichert. Dieser „Authoring“ genannte Teil der Produktionskette ist eine Besonderheit von Next Generation Audio. In ihm werden die Eigenschaften einzelner Audioobjekte über Metadaten definiert. Das ermöglicht dem Publikum neue Erlebnisse: Zum Beispiel können sie einen anderen Spielkommentator auswählen oder sich akustisch die Fankurve ins Wohnzimmer holen. Im Fall von MPEG-H Audio sind alle Metadaten Teil einer PCM-Audiospur, die framegenau mit Video- und den anderen Audioinhalten kombiniert wird. Die ermöglichten Personalisierungsoptionen sind eine einzigartige Neuerung des objektbasierten Audiosystems: Über sie kann dem Publikum zum Beispiel erlaubt werden, vom Kommentator der Heimmannschaft zum Kommentator des Gästeteams zu wechseln oder die Lautstärke der Sprecher anzupassen. Verschiedene Einstellungen können zu Presets kombiniert und über ein benutzerfreundliches Menü am Endgerät zur Auswahl gestellt werden.

Naturgemäß ändert sich in der Halbzeitpause die Art und Anzahl der Audiosignale signifikant, da die Liveübertragung durch Werbung oder andere Inhalte unterbrochen wird. Durch die robuste Metadatenstruktur bei MPEG-H Audio kann bei Bedarf ein abrupter Wechsel aller Metadaten im Live-Betrieb erfolgen. Damit ändern sich für das Publikum die in der Halbzeit zur Verfügung stehenden Interaktionsmöglichkeiten. Das bedeutet, dass nur die Inhalte angeboten werden, die zu diesem Zeitpunkt vorhanden sind.

Als letzter Schritt auf der Produktionsseite werden Audio- und Videosignale zusammengeführt und in einem gemeinsamen Arbeitsschritt encodiert. Für die Echtzeitcodierung und das Streaming über DASH wurde in Brasilien der TITAN Live Encoder von Ateme verwendet.

Mit flexiblen Benutzeroberflächen passen Zuschauende den Ton der Fußballübertragung an ihre Vorstellungen an.

Für die Präsentation der neuen Soundoptionen wurde eines der Globo-Studios in Rio de Janeiro mit spezieller Übertragungstechnik ausgestattet. Hierbei kam unter anderem ein LG-Fernseher zum Einsatz, mit dem der gesendete Livestream empfangen wurde. Hier konnten Zuschauende über eine MPEG-H Audio Benutzeroberfläche den Ton an ihre Präferenzen anpassen. Die Optionen, die zur Verfügung gestellt werden, sind durch die im Authoring erstellten Metadaten definiert, und beinhalten die dort festgelegten Auswahl- und Einstellungsoptionen. In diesem Fall konnte zwischen englischem und portugiesischem Kommentar ausgewählt, der Klang der Ball-Kicks erhöht oder abgesenkt, sowie der Gesang der Fankurven in seiner Lautstärke verändert werden.

In Rio de Janeiro ließ sich neben der Interaktivität auch der immersive Klang von MPEG-H Audio erleben. Mittels HDMI-Passthrough wird der MPEG-H Bitstrom vom Fernseher an MPEG-H Audio-fähige AVRs und Soundbars weitergeleitet, wo das Signal decodiert, gerendert und wiedergegeben wird. Während des Tests in Rio wurden so Sennheiser AMBEO Soundbars angeschlossen.

Eine App mit vielen Optionen in Südkorea

Die gleiche Weltmeisterschaft auf einem anderen Kontinent: Auch SBS, einer der führenden Fernsehsender Südkoreas, nutzte die Gelegenheit, eine Weltneuheit zu testen. MPEG-H Audio wird dort seit 2017 unter dem Standard ATSC 3.0 auf allen Sendern ausgestrahlt. Speziell für die Weltmeisterschaft entwickelte SBS eine Livestreaming-App, über die das Publikum die WM-Spiele sehen konnte: Mit dem ersten regulären MPEG-H Audiostreaming-Dienst mit personalisierbarem Ton. Die App machte es möglich, auf den WM-Stream zuzugreifen und den Ton an die eigenen Vorlieben anzupassen.

Wie in Brasilien basierte auch in Südkorea die Mischung auf dem 16-kanaligen Signal aus Katar. Dieses Mal entstanden im Authoring jedoch ausschließlich Presets. Solche Presets sind die einfachste Art der Interaktionsmöglichkeiten, da sie den Zuschauern beispielsweise verschiedene Mischungen anbieten, zwischen denen einfach umgeschaltet werden kann. So wird oft ein „Standard“-Preset verwendet, welches den Originalmix beinhaltet, und ein „Enhanced Dialog“-Preset, das bessere Sprachverständlichkeit bietet, indem der Hintergrund abgesenkt wird, wenn Sprache aktiv ist.

In der SBS-App konnte das Publikum zwischen den Voreinstellungen „Basic“, „Enhanced Dialog“, „Site“ und „Dialog Only“ wählen. Ein derartig hoher Personalisierungsgrad ist bei Livestreams von Sportereignissen ein absolutes Novum. In Südkorea entstand die Voreinstellung „Basic“ für Zuschauerinnen, die die gewohnte Audiowiedergabe schätzen. „Enhanced Dialog“ wartete mit einer lebendigeren Wiedergabe der Kommentatoren auf und „Site“ war darauf ausgelegt, die reine Stadionatmosphäre ohne Kommentar wiederzugeben.

Und Künstliche Intelligenz kann es auch: MPEG-H Audio in der Premier League

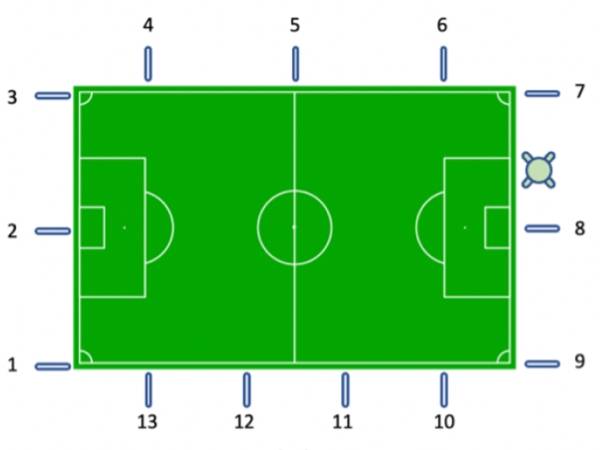

Oben haben wir gesehen, dass MPEG-H Audio in der Fußballübertragung für ein intensiveres Erleben sorgt. Doch schon weit bevor in der Sendeanstalt Audioobjekte konfiguriert werden, ist bereits viel Arbeit erfolgt, sozusagen direkt am Spielfeldrand. Während eines Fußballspiels wird eine große Anzahl an Mikrofonen verwendet, um das Spiel möglichst detailliert einzufangen. All diese Signale müssen gemischt und kontrolliert werden. In einem so anspruchsvollen Live-Produktionsumfeld sind effiziente und vor allem robuste Prozesse von entscheidender Bedeutung. Spitzensport ist einer der wichtigsten Treiber für Technologieentwicklung, in der immersiver Klang und Personalisierung aus der Übertragung schon nicht mehr wegzudenken sind und zum begehrten Wettbewerbsvorteil werden. Beides verlangt objektbasierte Ansätze, weswegen spezielle Tools für diese neuen Technologien in etablierte Prozesse integriert werden müssen – wenn möglich ohne Zusatzaufwand für Toningenieure. Und hier kommt Künstliche Intelligenz ins Spiel: KI-basierte Mixing-Software kann den Arbeitsaufwand von Toningenieuren deutlich reduzieren und damit Zeit für andersgelagerte Aufgaben schaffen. Zum Beispiel lassen sich mithilfe von Maschine Learning eine Vielzahl von Mikrofonsignalen verwalten.

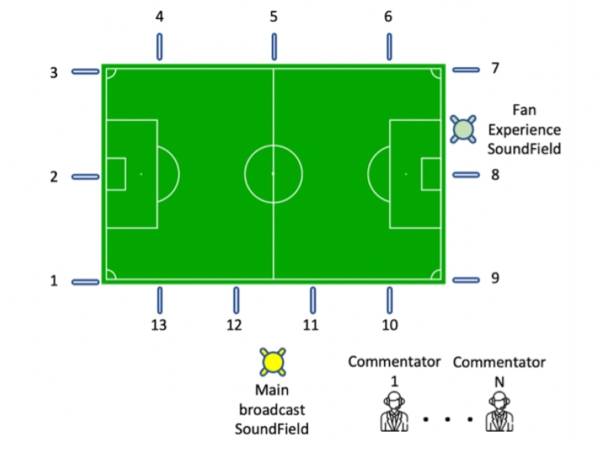

MixAir Workflow Flowchart: Vom Spielfeldrand zum TV: Next Generation Audio Technologien machen modernste TV-Erlebnissen möglich.

Das britische Unternehmen Salsa Sound verwendet diesen Ansatz bei Spielen der Premier League. Mit dem von Ihnen entwickelten Tool „MIXaiR“ werden eingehende Audiosignale automatisch zu Stems zusammengefasst. Diesen Prozess kann der Toningenieur steuern und kontrollieren und wird dabei erheblich durch die KI entlastet. Zum Beispiel mischt die „pitch assist“-Funktion mit KI-Unterstützung die Spielfeldmikrofone und übernimmt dabei auch die aufmerksamkeitsintensive Aufgabe, dem Ball über das Spielfeld zu folgen. So kann der Toningenieur die freiwerdende Zeit auf zusätzliche Authoring-Tätigkeiten verwenden, ohne dass dabei die Qualität der Mischung leidet.

Die zunehmende Verbreitung von Next Generation Audio Systemen wie MPEG-H Audio zeigt, dass die Kombination aus KI-Tools, Metadaten-Authoring und modernen Übertragungsoptionen die optimale Anpassung an Konsumgewohnheiten des heutigen Publikums ermöglicht. Dabei werden insbesondere in der Sportübertragung auf internationaler Ebene neue Herangehensweisen entwickelt und getestet.

Auch abseits vom Innovationstreiber Sport zeigt die zunehmende Verwendung von objektbasierten, KI-gestützten Audiosystemen, dass diese langsam in der breiten Verwendung ankommen: In den Online-Mediatheken deutscher Sender schaffen sie etwa Abhilfe bei schwer verständlichen Dialogen. Mit der KI-gestützten Technologie MPEG-H Dialog+ lässt sich aus bestehenden Audiomischungen eine alternative Version mit abgesenkten Geräuschen und Musik erzeugen. Auch hier kann man mit Audioobjekten für Personalisierungsmöglichkeiten wie anpassbare Dialoglautstärke sorgen.

Aimée Moulson

Aimée Moulson hat an der Universität Huddersfield einen Abschluss in Musiktechnologie und Audiosystemen erworben. Nachdem sie als Ingenieurin in der Rundfunkbranche gearbeitet hatte, erwarb Aimée Moulson ihren Master in Broadcast Engineering an der Birmingham City University. Seit 2021 arbeitet sie am Fraunhofer IIS als Toningenieurin und produziert immersive und objektbasierte Inhalte für das MPEG-H Audio-Ökosystem. Sie ist spezialisiert auf immersives Audio für Sportproduktionen und Systemintegration für Next Generation Audio Workflows.

Artikelthemen

Artikelübersetzungen erfolgen maschinell und redigiert.

Aimée Moulson

Aimée Moulson