7 Minuten

Die menschliche Stimme ist vermutlich das älteste, komplexeste und vielseitigste Musikinstrument. Und das am schwierigsten zu imitierende, sowohl analog als auch digital.

Die ersten erfolgreichen Versuche, eine vom Körper losgelöste sprechende Stimme zu erschaffen, gehen zurück ins 18. Jahrhundert.

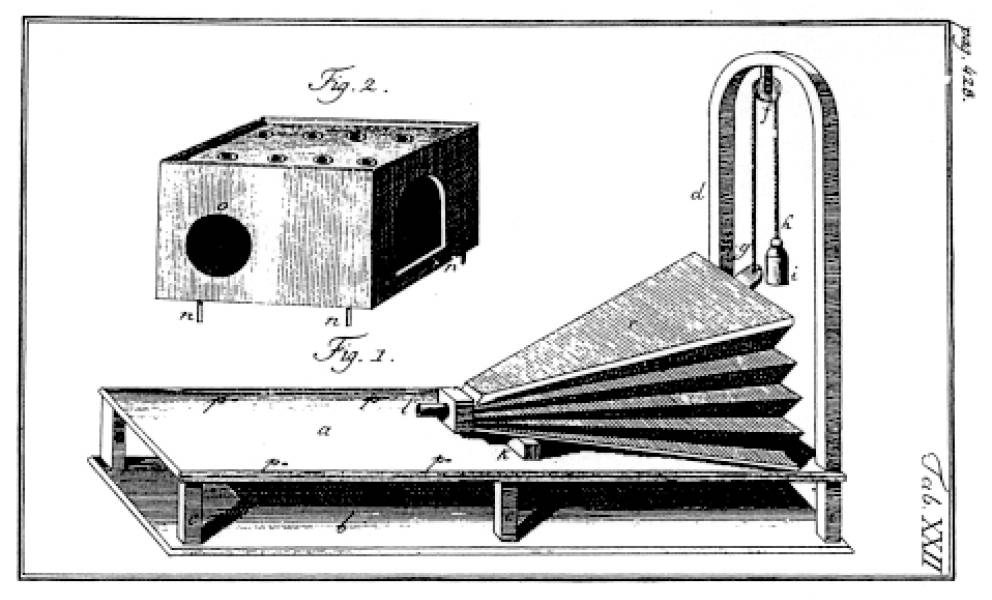

Wolfgang von Kempelen entwickelte die erste funktionierende Sprechmaschine, die zumindest einige verständliche Sprachlaute bilden konnte.

Von Kempelen versuchte, die menschlichen Sprechwerkzeuge mit Holz, Kautschuk, Leder und Elfenbein nachzuahmen. Der Apparat wurde mit Händen und Unterarm gespielt, die Verständlichkeit hing stark von der Virtuosität der Spielenden ab.

Auch die sprechenden Maschinen des 19. Jahrhunderts ähneln optisch und durch ihre Spielweise Musikinstrumenten: Die Sprechmaschine Euphonia wurde z.B. über eine Klaviatur und Fußpedale bedient und erinnert trotz der Inszenierung mit Frauenkopf stark an eine Orgel.

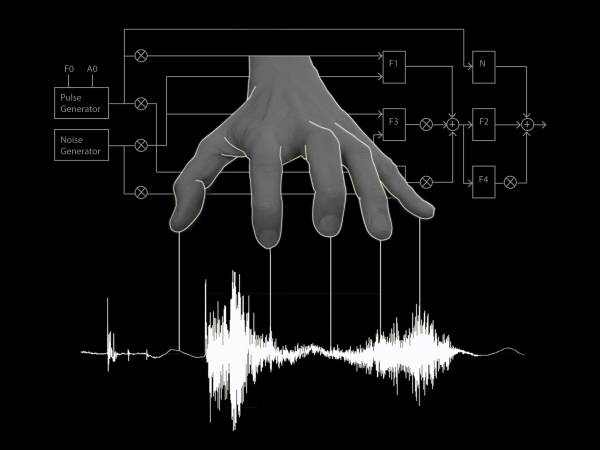

Die erste elektrisch erzeugte Sprechstimme – der Voder – schickte ein Quellensignal durch verschiedene veränderbare Filter, die mit Handtasten gesteuert wurden. Ein Handgelenksschalter wechselte zwischen stimmhaften und stimmlosen Lauten, ein Fußpedal steuerte die Grundfrequenz.

Obwohl diese ersten Sprechmaschinen alle nicht als Musikinstrumente, sondern zu wissenschaftlichen oder technischen Zwecken entworfen wurden, wurden sie wie Musikinstrumente gespielt.

Ihre Bedienung war eine sehr körperliche, auditiv-haptische, bei der die Sensomotorik unmittelbar mit Phonetik und Akustik der künstlichen Stimme verbunden war. Bewegung und Feinmotorik für das Spielen auf diesen Instrumenten mussten – oft durch jahrelanges Üben – erlernt und trainiert werden. Auch bei meinen im Folgenden beschriebenen selbstgebauten Interfaces für elektronische Stimme stehen die körperliche Spielweise und ihre Verbindung mit den Stimmklängen und Sprachlauten im Mittelpunkt.

Der Akt des Stimmen-Malens

Meine erste Arbeit zu künstlichen Stimmen begann mit Spektrogrammen:

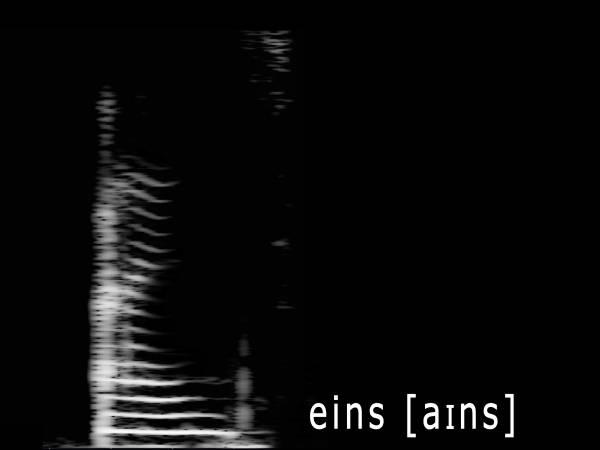

Spektrogramme sind Visualisierungen von Klängen: eine Auffächerung der Frequenzen auf einer Zeitachse – eine Art "Fingerabdruck" des Klanges, der seine spektralen Eigenschaften zeigt.

Spektrogramm des gesprochenen Wortes „eins“

Bereits in früheren Arbeiten habe ich Bilder in Klänge übersetzt, indem ich sie von links nach rechts entlang einer „Scanlinie“ mit Sinuston-Generatoren sonifiziert habe. Die Erfahrung, dass jedes Bild als Spektrogramm interpretiert und vertont werden kann, brachte mich auf den Gedanken, gezielt Klänge durch handgezeichnete Spektrogramme zu erzeugen – am meisten reizten mich dabei menschliche Stimmen.

Handgezeichnete Stimmen-Archive

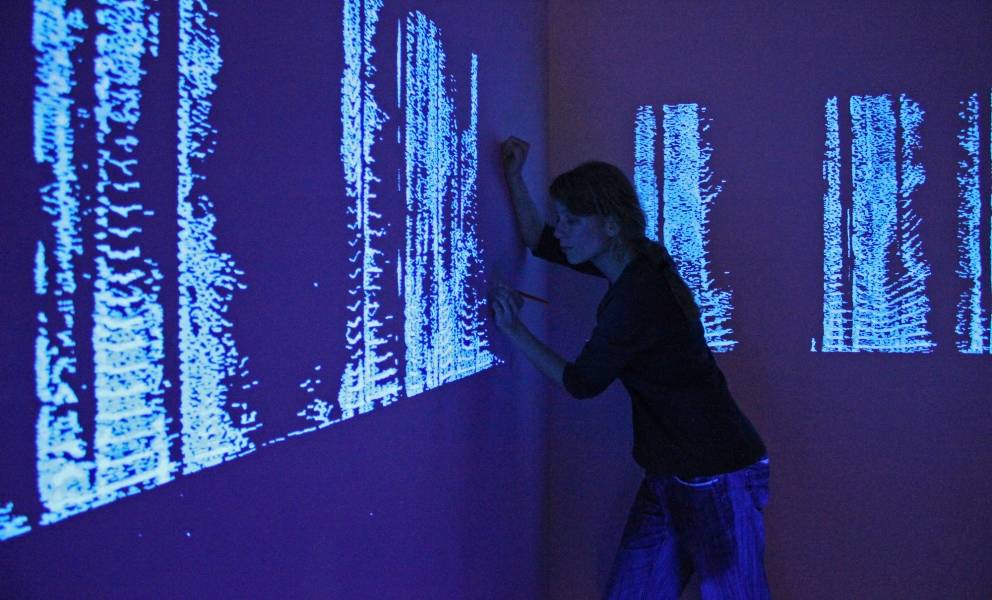

In der Arbeit "Ton auf Zeichnung" male ich Stimm-Spektrogramme mit UV-Farbe an die Wand. Es sind je nach Kontext Ausschnitte aus Interviews, poetische Texte oder Statements zu Sprache und Identität. Der Raum wird zu einem Archiv unhörbarer Stimmen, die unter bestimmten Bedingungen mit der Technik der inversen FFT (Fast-Fourier-Transformation) wieder hörbar gemacht werden können.

„Ton auf Zeichnung“ in der Ausstellung „FINE SOUND – keine medienkunst“, das weiße Haus, Wien

Dieser Akt des Stimmen-Zeichnens ist intensiv und aufschlussreich, aber als Prozess sehr aufwendig und langsam. Im Folgeprojekt „Klangkalligraphie“ realisierte ich die Idee, in einer Live-Performance Stimmen in Echtzeit zu zeichnen und gleichzeitig zu vertonen – also durch die Zeichnung zu "sprechen". Im Rahmen des PEEK Projekts "Digital Synesthesia" entwickelte ich ein kalligrafisches Zeichensystem, in dem Zeichen und spektral kodierter Laut verschmelzen. Durch sukzessive Reduktion der Spektrogramme von Sprachlauten fand ich die minimalste Form für jeden Laut, die noch genug Informationen enthält, um bei ihrer Vertonung als konkreter Sprachlaut erkannt zu werden, die aber gleichzeitig mit wenigen Strichen kalligrafisch gezeichnet werden kann.

In der Performance zeichne ich die Stimm-Kalligrafien auf Papier, während sie live von einer Kamera abgefilmt und im Loop vertont werden. So entsteht sukzessive – Wort für Wort – ein Text, der die handgemalte Stimme über ihre eigene – körperlose – Präsenz und Identität sprechen lässt.

Klangkalligrafie: Performance in der Ausstellung DIGITAL SYNESTHESIA, Angewandte Innovation Lab Wien

Diese künstlich erzeugte Sprechstimme ist zunächst kaum verständlich, mit jedem weiteren Strich wird es aber leichter, im Gehörten Sprachfragmente wahrzunehmen.

Die Hand und die Stimme – „sprechende und singende“ Performance-Instrumente

Bei meinen selbstgebauten Interfaces geht es mir generell darum, digitale und elektronische Klänge mit dem Körper ansteuern und spielen zu können und dabei durch den Einsatz von Sensoren eine sinnvolle Verbindung zwischen Aktion/Körperreaktion und Klang herzustellen – ähnlich wie bei einem klassischen Musikinstrument. Durch die Integration körperinnerer Vorgänge als Steuersignale wird der Körper noch unmittelbarer in das Musikinterface eingebunden.

In den letzten Jahren entwickelte ich eine Reihe von Interfaces für elektronische Stimme. Ziel war, in meinen musikalischen Live-Performances mit künstlich erzeugter oder transformierter Stimme zu arbeiten: Ich entwarf diese Instrumente, um einerseits die eigene Stimme elektronisch zu erweitern und vom Körper zu lösen, andererseits künstliche Stimmen als eine Art digitaler Ventriloquismus mit Gesten und Körperbewegungen zu steuern.

Bei den Stimm-Interfaces geht es speziell darum, mich der Stimme in ihrer Komplexität mit den Input-Daten anzunähern und die wesentlichsten Parameter individuell steuern zu können.

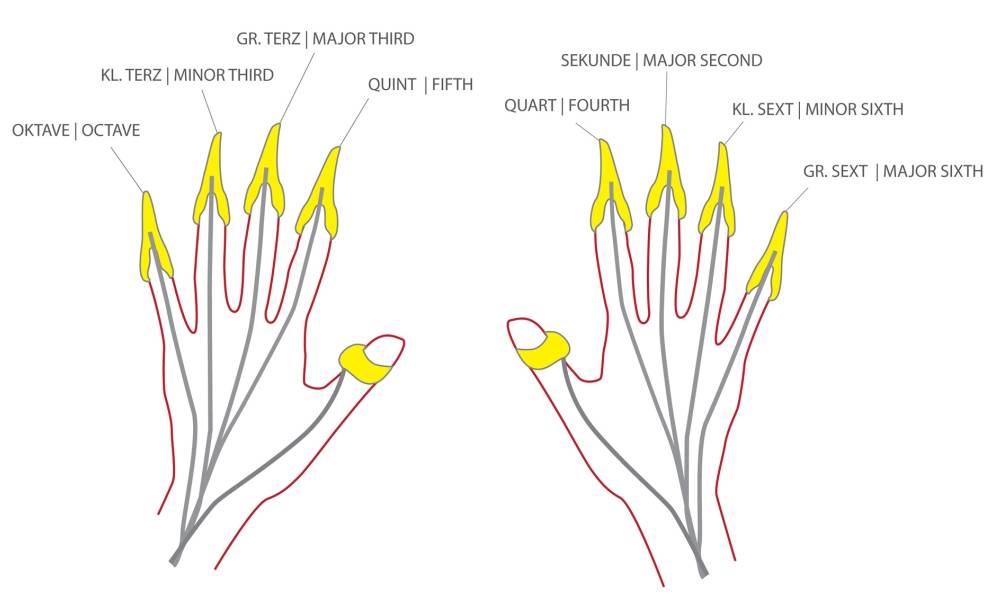

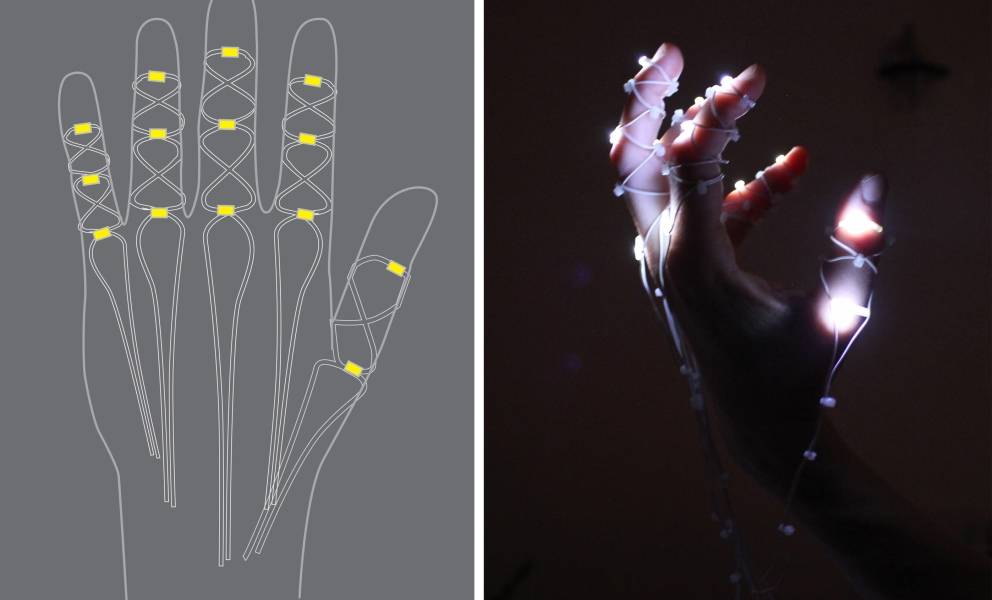

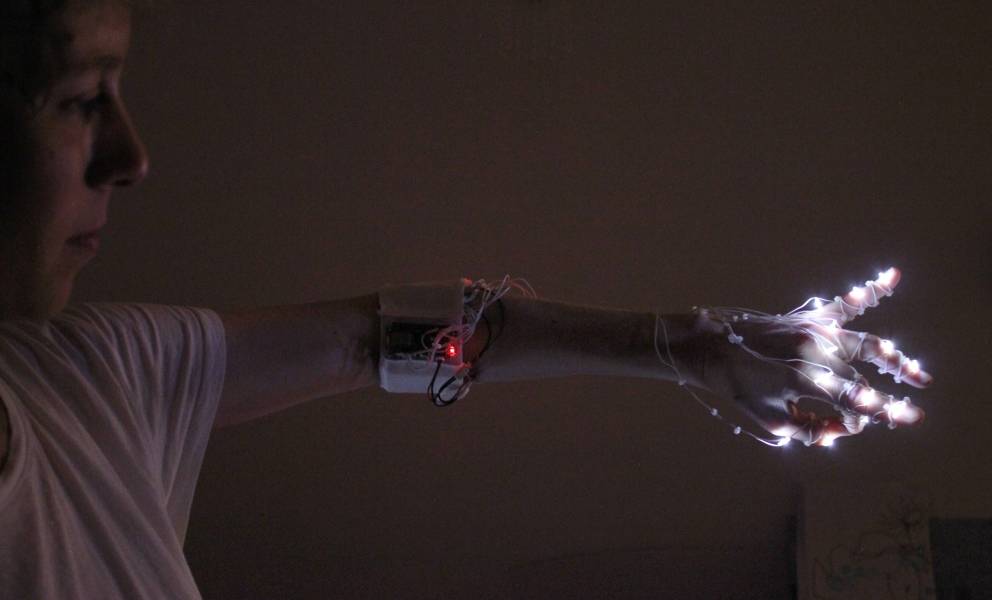

Als erstes Live-Instrument für die Stimme entwickelte ich den Fingertip-Vocoder: ein an den Fingern getragenes – zunächst verkabeltes, später über USB mit dem Computer verbundenes – Interface. Fingerspitzenringe aus Messing funktionieren als Sensorschalter und steuern einen Pure-Data-Patch, der die Stimme der Performerin in bestimmten Intervallen vervielfacht und so mehrstimmige Klänge erzeugt – der Fingertip-Vocoder ermöglicht es, solo ein Chorstück zu singen. Die Akkorde werden durch Kombinationen von Fingerspitzen-Berührungen erzeugt, die ähnlich wie Fingersätze auf dem Klavier gelernt und verinnerlicht werden müssen.

Ich erweiterte den Funktionsspielraum des Fingertip-Vocoders durch die zusätzliche Verwendung eines Leap-Motion-Controllers. Dieser Infrarot-Sensor erfasst die Position der Hände und Finger im Raum. Somit können – zusätzlich zur Aktivierung der einzelnen Stimmtranspositionen – weitere Parameter gesteuert werden: Die Links-rechts-Bewegung der Hand kann z.B. die einzelnen Stimmen fließend zwischen linkem und rechtem Kanal bewegen und im Raum verteilen.

Ich begann, auch spektral mit live eingesprochenem/eingesungenem bzw. künstlich generiertem Stimm-Material zu arbeiten. Ich navigiere dabei durch die Audiospur wie durch eine imaginäre dreidimensionale Form im Raum – die Bewegung der Hand steuert sozusagen den Cursor, der das Soundfile abtastet. Die Stimmklänge können an jeder beliebigen Stelle „eingefroren“ werden und bleiben als anhaltender Ton oder Rauschen – je nachdem, welcher Laut gerade gesprochen oder gesungen wird – im Raum stehen.

Die Musikalität, die in der gesprochenen Sprache selbst steckt, wird dabei spürbar.

Lichtscans durch den Körper der Stimme

Im Projekt „Talking Hands“ ersetzte ich die Fingerspitzenringe programmiertechnisch durch die genaue Positionsbestimmung der Fingerkuppen mit dem Leap-Sensor und entwarf ein netzartig über Hände und Finger verlaufendes LED-Interface, das sichtbar macht, welche Soundspur gerade aktiv ist und wo im „Stimmraum“ ich mich gerade bewege.

Beim ersten Prototyp der „Talking Hands“ kombinierte ich Gesten und Bewegungen mit dem Sprachsynthesizer DECtalk. Finger- und Handgesten aktivieren Laute, die von DECtalk vertont werden und als Sound in Echtzeit mit MaxMsp verarbeitet werden. Die Bewegung der Hand im Raum kann die Intonation und Lautstärke steuern. Ein dynamisches (melodisches) Sprechen ist zumindest in Grundzügen möglich.

Mich reizte es jedoch, mit einer künstlichen Stimme zu arbeiten, die natürlicher klang, und sie mit den Gesten über das Interface spektral zu erforschen. Auf der Plattform Resemble AI generierte ich eine Stimme für „Talking Hands“, modelliert auf Basis meiner eigenen Sprechstimme. Diese kann via Python in einen Live-Workflow eingebunden werden und ich verwende sie als Grundlage für das spektrale Spiel mit dem Klang in MaxMSP: Die Hand navigiert durch die Zeitspur und wandert gleichzeitig durch die vertikalen Schichten der Stimme – verschiedene Bereiche im Obertonspektrum werden hervorgehoben oder verfremdet, die Klangfarbe verändert sich durch subtile Fingerbewegungen und Drehung der Hand.

Digitale Chöre und die Stimme als Saiteninstrument

In meiner aktuellen Performance „All of my voices“ gehe ich von minimalen Stimm-Inputs aus und generiere daraus einen artifiziellen Chor, der sich sukzessive im Raum entfaltet – initiiert und dirigiert vom Fingertip-Vocoder. Im zweiten Teil der Performance spiele ich den „Stimmbogen“ – ein weiteres elektronisches Interface, mit dem ich die menschliche Stimme zu einem Saiteninstrument transformiere, indem ich sie als Tonspur auf ein Monochord mappe. Im Stimmbogen verschmilzt die Stimme mit der Saite und entfaltet ihr Potential als manuell gespieltes Live-Instrument: Von perkussiven Konsonanten bis zu gestrichenen Vokalen reicht das Spektrum an haptischen und intuitiven Ausdrucksformen dieses Interfaces für das Medium der elektronischen Stimme.

Weitere Entwicklung

Technisch liegt das Potential zur Weiterentwicklung meiner Stimm-Interfaces in den Fortschritten der KI-basierten Stimm-Synthese.

Die Klangqualität der KI-Stimmen ist mittlerweile sehr hochwertig, doch die höhere Latenz im Vergleich zu klassischen Stimmgeneratoren wie DECtalk kann bei Echtzeit-Anwendungen in Live-Performances störend sein. Daher interessiert es mich auch, ein Vokaltrakt-Modell einzusetzen, das Parameter wie Form und Position von Lippen oder Zunge direkt mit Sensorwerten ansteuert. Ein virtueller Vokaltrakt könnte intuitiv und in Echtzeit über ein Interface manipuliert werden, wodurch auch nonverbale und experimentelle Klänge erzeugt werden können.

Musikalisch arbeite ich daran, die ursprünglichen Funktionen des „Fingertip Vocoders“ – die Erweiterung der natürlichen Stimme durch Transposition – mit den spektralen Klangprozessen der „Talking Hands“ zu verbinden. Ziel ist es, einen noch fließenderen Übergang zwischen meiner eigenen Stimme und den sensor-gesteuerten synthetischen Klanggestalten und Stimm-Artefakten zu schaffen.

Als Live-Instrument eröffnet mir die sensor-basierte Stimme fortlaufend neue Entwicklungsfelder und musikalische Entfaltungsräume.

Ulla Rauter

Ulla Rauter arbeitet als Medienkünstlerin und Musikerin an der Schnittstelle von Klangkunst und Bildender Kunst – ihre Werke umfassen performative Skulpturen, musikalische Performances und selbstgebaute Instrumente. Ihre sensorbasierten, elektronischen Musikinstrumente werden international in Performances und Ausstellungen gezeigt. Zentrale Themen in ihrer künstlerischen Arbeit sind die Stille als Material und Sehnsuchtsort und die menschliche Stimme als Ausgangsmaterial für Übersetzungs- und Transformationsprozesse. Ulla Rauter ist Mitbegründerin und Organisatorin der jährlichen Hörschau Klangmanifeste. Seit 2013 unterrichtet sie an der Abteilung Digitale Kunst der Universität für Angewandte Kunst Wien.

Artikelthemen

Artikelübersetzungen erfolgen maschinell und redigiert.

Ulla Rauter

Ulla Rauter