8 Minuten

In den frühen 1980er Jahren führte das Team für Raumakustik bei Ircam umfangreiche Forschungsarbeiten zur Charakterisierung der akustischen Qualität von Aufführungsorten wie Auditorien, Theatern oder Opernhäusern durch. Die Wirkung des Nachhalls in diesen Räumen kann aus verschiedenen Perspektiven beschrieben werden:

- Vom architektonischen Standpunkt aus betrachtet bezieht es sich auf geometrische und physische Eigenschaften des Raums, wie Form, Größe und Wandmaterial.

- Aus der Sicht eines Akustikers in Bezug auf objektive Messgrößen (wie die Nachhallzeit), die anhand einer am Veranstaltungsort gemessenen Impulsantwort berechnet werden.

- Oder aus der Sicht der Wahrnehmung: Ausdruck von Empfindungen des Publikums wie "Intimität" oder "Süße", ähnlich wie man das Timbre eines Klangs oder den Geschmack eines Weins beschreiben würde.

Das Team unter der Leitung von Jean-Pascal Jullien und Olivier Warusfel konzentrierte sich auf den letztgenannten Wahrnehmungsansatz und ermittelte eine kleine Anzahl subjektiver Parameter, die das Hörerlebnis eines Musikkonzerts charakterisieren. Anhand dieser Parameter ("die Zutaten") erarbeiteten sie ein Wahrnehmungsmodell ("das Kochrezept") zur Steuerung eines künstlichen Hallgeräts.

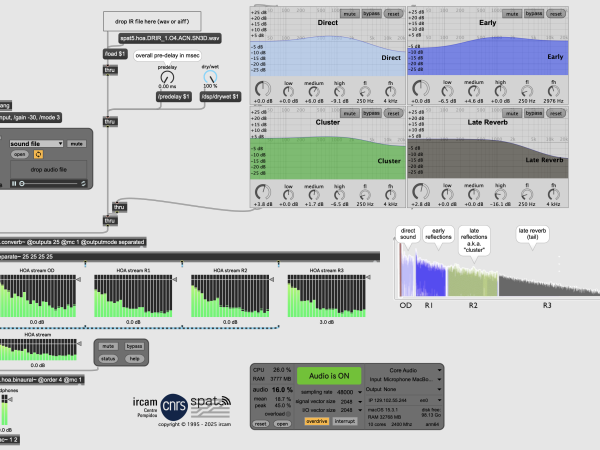

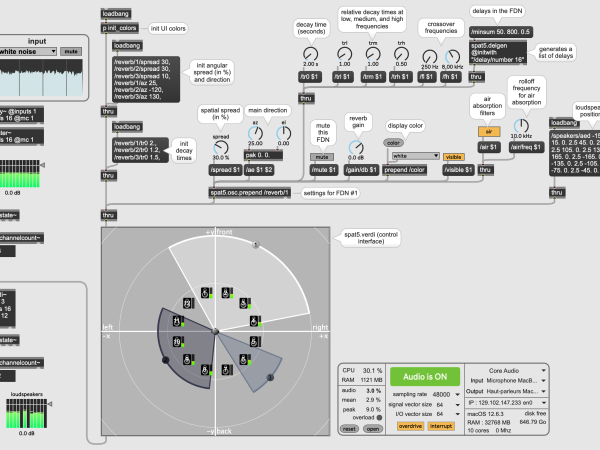

Anfang der 1990er Jahre wurden Mehrkanal-Digitalhallgeräte dank der von Jean-Marc Jot entworfenen Feedback-Delay-Network-(FDN-)Architektur realisierbar, und die Max-Umgebung wurde entwickelt. Dies führte zur Geburt des Spat-Projekts: ein räumliches künstliches Hallgerät, das in Echtzeit in Max läuft und über eine Wahrnehmungsschnittstelle gesteuert wird. Diese High-Level-Kontrollschnittstelle ist ideal für künstlerische Produktionen, da sie eine intuitive Möglichkeit zur Konfiguration der Reverb-Engine bietet und eine nahtlose Interpolation zwischen verschiedenen akustischen Qualitäten ermöglicht. Bemerkenswerterweise wurde das Spat-Framework auch mit einer objektbasierten Beschreibung des Raumeffekts implementiert, und zwar Jahrzehnte vor der Entwicklung der heute gebräuchlichen objektbasierten Formate: Direktschall und frühe Reflexionen erhalten eine genaue Position (und Ausrichtung) im Raum, während der späte Nachhall als diffuses "Bett" kodiert wird. Dies ermöglicht eine universelle räumliche Szenendarstellung und gewährleistet die (Tool-)Agnostizität des Layouts, d. h., der Inhalt wird automatisch an jede beliebige Lautsprecherkonfiguration (oder Kopfhörer) angepasst.

Im Laufe der Jahre und der aufeinanderfolgenden Versionen von Spat wurden diese einzigartigen Eigenschaften beibehalten. Die Spat-Bibliothek hat sich jedoch auch weiterentwickelt und wichtige neue Entwicklungen aufgenommen, die die Welt der räumlichen Audiotechnik in den letzten Jahrzehnten revolutioniert haben.

In den folgenden Abschnitten werden einige der wichtigsten Merkmale der Bibliothek hervorgehoben.

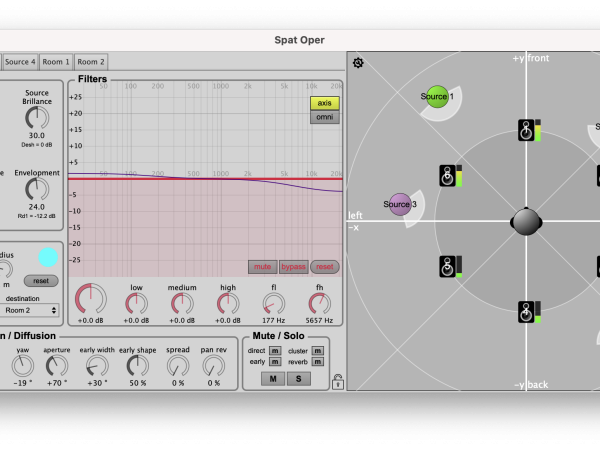

Spat5.oper implementiert ein Wahrnehmungsmodell zur Steuerung der (virtuellen) raumakustischen Qualität.

Künstlicher Nachhall

Eine Schlüsselkomponente von Spat ist die Raum-Engine, die von einer FDN-Einheit angetrieben wird und natürlich klingende Halleffekte erzeugt. Dieses Modul ist hochgradig skalierbar: Während es in der Regel 8 bis 16 interne Rückkopplungskanäle für eine optimale Berechnungseffizienz verwendet, kann diese Anzahl erhöht werden, um extrem dichte oder lange Nachhalleffekte zu erzielen (optional mit unendlicher Nachhallzeit). Außerdem kann die Abklingrate über mehrere Frequenzbänder hinweg eingestellt werden. Obwohl drei Bänder (Low/Mid/High) in der Regel ausreichen, um die meisten konventionellen Räume zu emulieren, eröffnet die Verwendung einer feineren spektralen Auflösung (bis zu 30 Bänder) mehr experimentelle Klanggestaltungsmöglichkeiten.

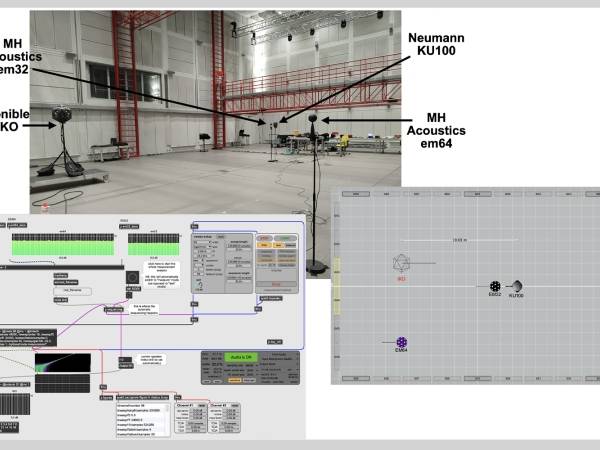

Neben dem algorithmischen Nachhall wird auch die auf Faltung basierende Technik unterstützt. Das Objekt spat5.converb~ beispielsweise ist eine Faltungs-Engine, die effiziente und latenzfreie FFT-Algorithmen implementiert. Es simuliert den Nachhall eines Raums auf der Grundlage seiner Mehrkanal-Impulsantwort (IR). Das Objekt bietet auch einige Einstellungs- und Gestaltungsmöglichkeiten: Die IR kann in mehrere zeitliche Segmente (Direktschall/frühe Reflexionen/später Nachhall) aufgeteilt werden, und auf jedes Segment können spektrale oder räumliche Effekte angewendet werden, was die Gestaltung einer völlig neuen IR ermöglicht. Das Spat-Paket enthält auch ein Hilfsprogramm (spat5.smk∼), das die Swept-Sinus-Technik zur Erfassung von IRs von halligen Räumen verwendet.

Beispiel einer IR-Messung mit spat5.smk~ in Ircams Espace de Projection

Spat5.converb~ Faltung einer Ambisonic-IR mit parametrischen Filtern, die auf die direkten/frühen/späten Anteile der IR angewendet werden.

Richtungsabhängige Nachhallzonen in spat5.verdi

Panning

Es gibt eine Vielzahl von Panning-Algorithmen, die jeweils ihre eigenen Stärken und Grenzen haben. VBAP zum Beispiel ist sehr beliebt für seine Fähigkeit, "punktförmige" virtuelle Quellen zu erzeugen, während Ambisonics häufig verwendet wird, um immersive Umgebungen zu schaffen. Sicherlich gibt es keine "Einheitsgröße" für alle Räumlichkeitstechniken. Deshalb unterstützt Spat alle modernen Panning-Techniken und bietet dem Anwender die Möglichkeit, diese je nach Beschaffenheit des Klangmaterials oder des gewünschten räumlichen Effekts zu mischen. Zusätzlich zu VBAP und Ambisonics beinhaltet die Toolbox auch die Wellenfeldsynthese (WFS). Jede Lautsprecherkonfiguration, ob 2D oder 3D, kann potenziell mit WFS verwendet werden, obwohl bestimmte räumliche Effekte, wie z. B. fokussierte Schallquellen (die sich innerhalb des Hörbereichs befinden), aufgrund von räumlichen Aliasing-Beschränkungen ausreichend dichte Lautsprecherarrays erfordern. Das Panning-Modul (spat5.pan~) implementiert außerdem die binaurale Synthese mit optionaler Simulation von Nahfeldeffekten, konventionellen Stereotechniken (AB, XY, MS) und abstandsbasierten Panning-Ansätzen (wie DBAP und KNN).

Beliebige Lautsprecheranordnungen können mit spat5.virtualspeakers∼ über Kopfhörer abgehört werden. Dieses Tool nutzt HRTF, um einen beliebigen Mehrkanal-Stream in eine binaurale Stereospur zu konvertieren, wobei die räumlichen Eigenschaften der ursprünglichen Klangszene erhalten bleiben.

Ambisonic Workflow

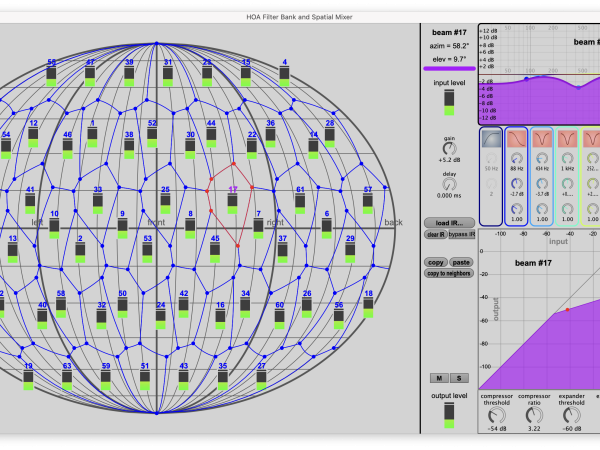

Higher-Order-Ambisonic-(HOA-)Technologien haben seit den 2000er Jahren sowohl in der Wissenschaft als auch in der Medienindustrie großes Interesse geweckt. Modernste Werkzeuge zur Nutzung des HOA-Produktionsworkflows wurden in die Spat-Bibliothek integriert. Dazu gehören insbesondere:

- A-zu-B-Format-Encoder, die Mikrofonsignale in den Ambisonic-Bereich umwandeln. Gängige Mikrofonarrays erster Ordnung (Sennheiser Ambeo, Soundfield, Tetramic usw.) und höherer Ordnung (z. B. MH Acoustics em32 und em64 oder Zylia ZM1) werden unterstützt.

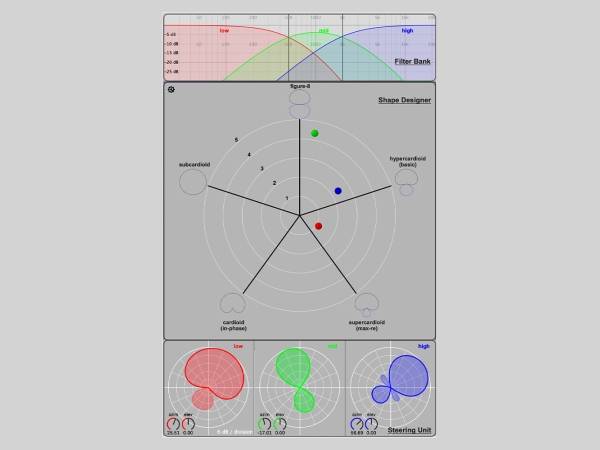

- Eine umfangreiche Sammlung von Werkzeugen für die Anwendung von räumlichen Effekten auf Ambisonic-Streams, wie z. B. 3D-Drehungen, Spiegelung, Richtungsverbesserung (oder "Fokus"), Warping (Quetschen oder Dehnen der Szene in eine bestimmte Richtung), Unschärfe usw. Ambisonic-Beamforming (spat5.hoa.beam~) und Spatial Filter Bank sind weitere verfügbare Techniken, die lokalisierte Klangveränderungen in bestimmten Bereichen des Raums ermöglichen. Diese Sammlung von Max-Objekten bietet eine breite Palette an kreativen Manipulationen, die besonders bei der Bearbeitung von Soundfield-Aufnahmen nützlich sind.

- Eine Vielzahl von Decodern, die mit regelmäßigen oder unregelmäßigen Lautsprecheranordnungen zurechtkommen, wie z. B. der Mode-Matching-Ambisonic-Decoder (MMAD), der Energy-Preserving-Decoder (EPAD), der All-Round-Ambisonic-Decoder (AllRad) und andere.

Ambisonics-Streams können auch binaural mit der so genannten Magnitude-Least-Squares-Technik (MagLS) überwacht werden, die eine optimale Klangfarbentreue garantiert.

Räumlich lokalisierte Soundeffekte, die mit spat5.hoa.beamix~ auf einen Ambisonic-Stream angewendet werden.

Directivity Designer zur Gestaltung lenkbarer Beam Patterns, die mit Ambisonic-Mikrofon- oder Lautsprecher-Arrays kompatibel sind.

Object-based audio

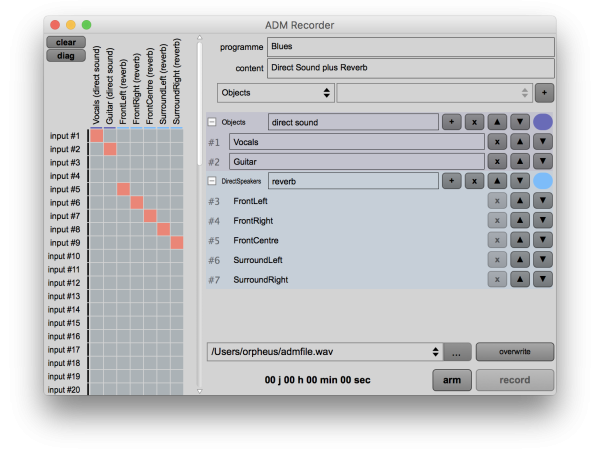

In den letzten zehn Jahren hat das Interesse am objektbasierten Ansatz für die Erstellung und Übertragung von Mehrkanalton stark zugenommen. Es wurden mehrere Austauschformate vorgeschlagen, wobei das Audio-Definition-Model (ADM) ein bemerkenswerter offener Standard ist, der von der ITU und der EBU veröffentlicht wurde und auch als Grundlage für Dolby-Atmos-Masterdateien dient. ADM wurde entwickelt, um objektorientierte Medien zu beschreiben, die in einem Broadcast-Wave-Format-(BWF-)Container gekapselt sind. ADM schreibt eine Reihe von Metadaten (z. B. die zeitlich veränderliche Position und Verstärkung von Audioobjekten) vor, die in der BWF-Datei in einem XML-Chunk kodiert sind. Die Spat-Toolbox bietet eine vollständige Produktionskette für BWF-ADM-Dateien. So ermöglicht spat5.adm.record∼ die Erstellung von BWF-Dateien mit eingebetteten Spatialization-Metadaten und spat5.adm.renderer∼ das Echtzeit-Rendering/Monitoring von ADM-Medien über verschiedene Wiedergabe-Setups (Kopfhörer oder Lautsprecher-Layouts). Andere spat5-Module ermöglichen auch eine grundlegende Interaktivität mit dem objektbasierten Inhalt.

Konfigurieren einer ADM-Session mit zwei Objekten und einem Hallbett in spat5.adm.record~

Kreative Werkzeuge für räumliches Authoring

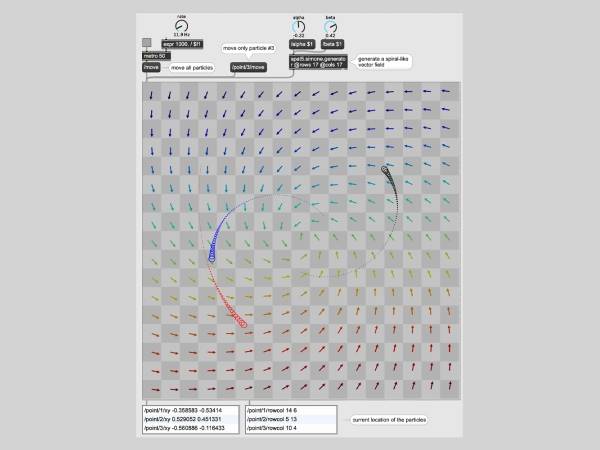

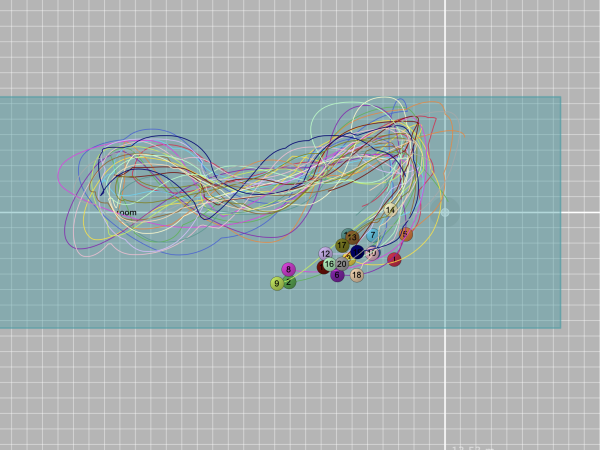

Bei der räumlichen Klangerzeugung werden meist geometrische Daten manipuliert, entweder für die Konfiguration des Wiedergabesystems oder für kreativere Zwecke. Insbesondere die Mehrkanalkomposition verwendet häufig das Paradigma der räumlichen Trajektorien, bei dem die Bewegungen der Klangquellen als Pfade, Kurven, parametrische oder zufällige Muster im Raum wahrgenommen werden. Zu diesem Zweck enthält die Spat-Bibliothek eine Sammlung von Werkzeugen zur Erzeugung, Transformation und Manipulation geometrischer Daten: spat5.trajectories bietet mehr als 50 parametrische Gleichungen für 2D- oder 3D-Kurven; spat5.boids implementiert eine klassische Simulation eines Vogelschwarms; spat5.simone berechnet die Bewegung von "Partikeln" in einem Vektorfeld und erzeugt flüssige und realistische Bewegungen autonomer Agenten; das OSCar-Plugin ermöglicht die Kommunikation von Koordinatendaten mit einem DAW-Automatisierungssystem; usw.

Neben diesen Objekten zur Ratenkontrolle enthält das Paket auch eine Reihe von Audioeffekten, die bei der Mehrkanalkomposition nützlich sein können, z. B. einen Simulator für Leslie-Lautsprecher (mit rotierendem Horn und Tieftöner) oder einen räumlichen Granulator, der Klangkörner im Raum verteilt.

Spat5.simone mit drei Partikeln (rot, blau und schwarz), die durch das darunterliegende Vektorfeld animiert werden.

Schwarm sich autonom bewegender Quellen in spat5.boids

Key characteristics

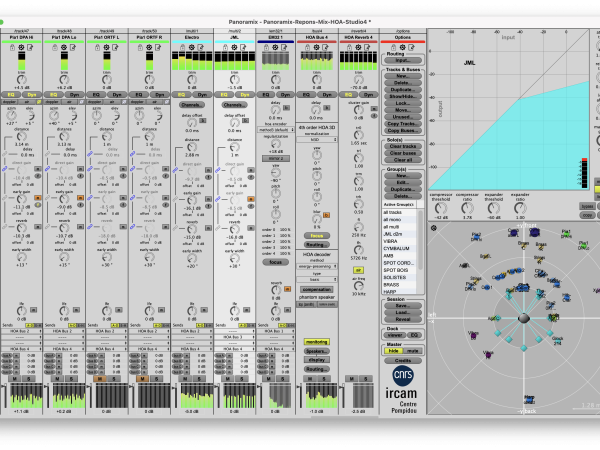

- Mehr als 300 Objekte, die die modernsten Techniken für Panning (Ambisonics, WFS, binaural etc.) und künstlichen Nachhall unterstützen Modularität und Vielseitigkeit: von der benutzerfreundlichen GUI (z.B. die spat5.panoramix-Workstation) – die ohne jegliche Vorkenntnisse der Max-Programmiersprache konfiguriert werden kann – bis hin zu Low-Level-Modulen, die frei gepatcht und angepasst werden können,

- Hochgradig optimierte DSP-Engine. Ermöglicht das Echtzeit-Rendering von komplexen Szenen mit einer großen Anzahl von Elementen,

- Vollständig steuerbar über das OSC-Protokoll,

- Umfangreiche Dienstprogramme für die Bearbeitung von Mehrkanal-Streams oder Dateien,

- Frei verfügbar über das Ircam-Forum

Zusammenfassung

Kurz gesagt ist Ircam Spat eine umfassende Bibliothek für die räumliche Klangdarstellung und künstlichen Nachhall, die in der Max-Umgebung implementiert ist. Mit über 300 Modulen kann das Toolkit in einer Vielzahl von immersiven Produktionen eingesetzt werden. Das Paket enthält außerdem eine Fülle von Dokumentationen und Tutorials.

Angeregt durch Forschungsergebnisse, technologische Innovationen und künstlerische Herausforderungen bleibt Spat ein sich ständig weiterentwickelndes Framework. Kurzfristige Perspektiven konzentrieren sich insbesondere auf die Erfassung, Analyse und Manipulation von 3D-Raumimpulsantworten im HOA-Bereich sowie auf die Nutzung objektbasierter Audioformate für die interaktive Navigation mit 6 Freiheitsgraden für VR/AR-Anwendungen.

Thibaut Carpentier

Thibaut Carpentier ist Forschungs- und Entwicklungsingenieur am IRCAM (Institut de Recherche et de Coordination Acoustique/Musique) in Paris. Nach seinem Studium der Akustik an der Ecole Centrale und der Signalverarbeitung an der ENST Telecom Paris trat er 2008 dem CNRS (Centre national de la recherche scientifique) und der Acoustics & Cognition Research Group bei. Seine Forschungsschwerpunkte sind räumliche Audiowiedergabe, Raumakustik, künstlicher Nachhall und Computerprogramme für 3D-Komposition und -Mischung. In den letzten Jahren war er für die Entwicklung von Ircam Spat verantwortlich, er schuf die 3D-Mischstation Panoramix und er trug zur Gestaltung und Umsetzung eines 350-Lautsprecher-Arrays für die holophone Klangwiedergabe in Ircams concert hall bei.

Artikelthemen

Artikelübersetzungen erfolgen maschinell und redigiert.

Thibaut Carpentier

Thibaut Carpentier