5 Minuten

Im letzten Jahr haben wir viel über KI-Musik gehört, wobei Instant-Song-Generatoren wie Suno und Udio den öffentlichen Diskurs dominieren. Dabei handelt es sich um kommerzielle Anwendungen mit geschlossenem Quellcode, was bedeutet, dass Entwickler von Drittanbietern nicht darauf aufbauen oder sie in ihre Plattform integrieren können.

Aber schon einige Jahre vor dieser jüngsten Welle der Audiogenerierung haben große Technologieunternehmen wie Google und OpenAI mit Open-Source-KI-Modellen zur MIDI-Generierung experimentiert.

Googles Open-Source-KI-MIDI-Modell hieß Magenta (2016), während das von OpenAI Musenet (2019) hieß. OpenAI stellte MuseNet in derselben Woche ein, in der ChatGPT startete, vermutlich um seine Serverleistung auf das LLM zu konzentrieren.

Magenta hingegen läuft problemlos auf einem lokalen Gerät und verbraucht nur wenig Speicher oder Ressourcen. Sie hatten ein paar Browser-Anwendungen für öffentliche Experimente und brachten eine kostenlose Suite von MIDI-VSTs namens Magenta Studio auf den Markt.

Als langjähriger Musiker und Softwareentwickler haben mich meine Erfahrungen mit Magenta und MuseNet inspiriert. Es war klar, dass sich die Entwicklerteams mehr auf das KI-Modell als auf die Benutzererfahrung und die Benutzeroberfläche konzentrierten. Ich hatte das Gefühl, dass es eine Möglichkeit gab, eine Web-App zu entwickeln, die an Magenta anknüpft, aber mit einem farbenfroheren Look and Feel.

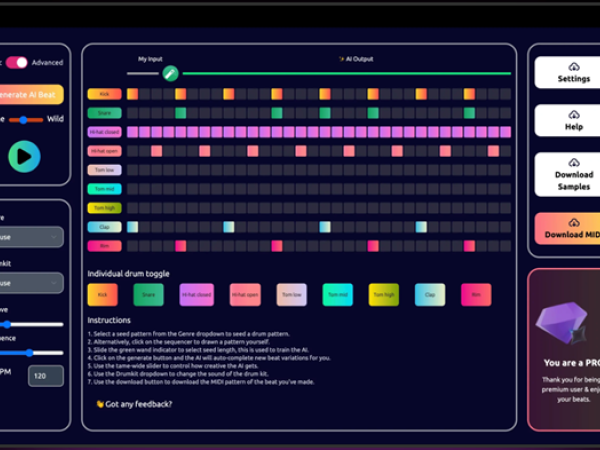

In den letzten zwei Jahren habe ich diesen Traum durch eine Webanwendung namens Drumloop AI zum Leben erweckt. Der Sequenzer verwendet das Magenta-AI-MIDI-Modell, um synkopierte Linien zu erzeugen, und AI-Audiomodelle, um kurze loopfähige Samples und Breaks zu erstellen. Wir haben derzeit über 65.000 registrierte Benutzer und wachsen Monat für Monat.

Google Magenta Studio

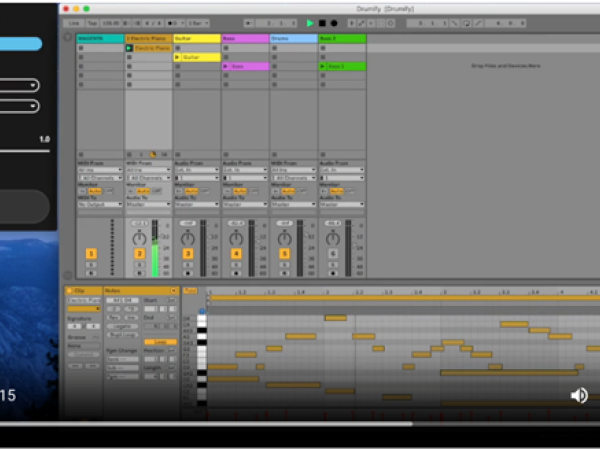

Für diejenigen, die mit Magenta nicht vertraut sind, könnte es hilfreich sein, zunächst einen Blick auf Googles Studio-Schnittstelle zu werfen. Ich zeige Ihnen insbesondere das Drumify-Plugin, um Ihnen ein Gefühl dafür zu geben, wie begrenzt es war. Das Plugin läuft auf dem Open-Source-MIDI-Generator DrumRNN (kurz für recurrent neural network), und das ist das Modell, auf dem wir DrumLoop AI aufgebaut haben.

Das VST nimmt eine perkussive MIDI-Referenzdatei auf und erzeugt dann Variationen davon. Wie Sie im Screenshot unten sehen können, handelt es sich um eine extrem leichtgewichtige Schnittstelle, die stark von der Pianorolle und den Sequenzern einer DAW abhängt, um mit dem eigentlichen Musizieren zu beginnen.

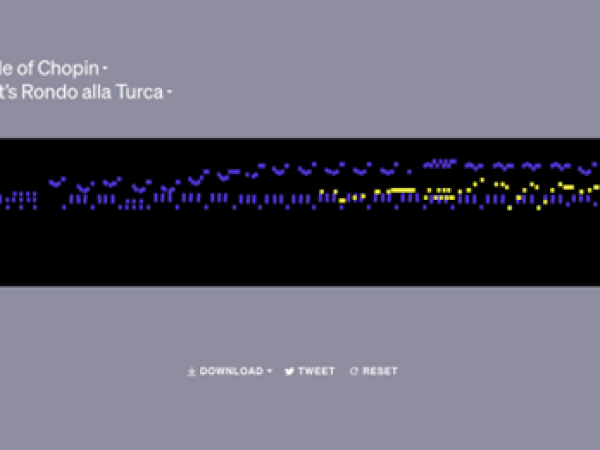

Das AI-MIDI-Werkzeug Musenet von OpenAI

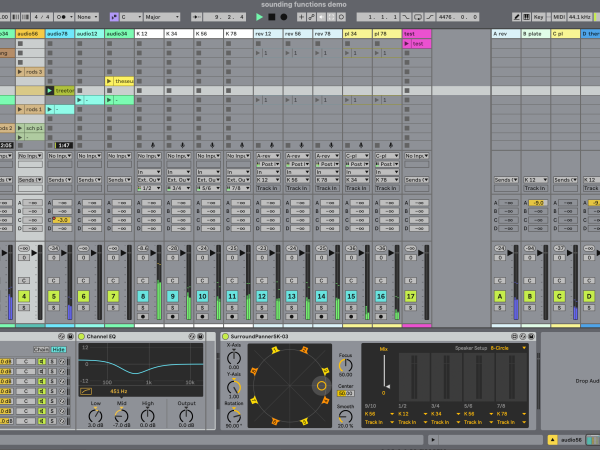

Das Musenet von OpenAI war ein zweites, beliebtes AI-MIDI-Tool, das MIDI-Eingaben entgegennahm und dann eine "Continue"-Funktion verwendete, um diese Idee zu erweitern. Sie können die Klavierrolle und vier horizontale Linien darunter sehen. Diese vier Balken sind anklickbar und zeigen vier "Erweiterungs"-Variationen an.

Das war das Ausmaß ihrer Schnittstelle zum Musikmachen! Sie können sich also vorstellen, wie sehr sich ein Indie-Hacker und Musiker wie ich motiviert fühlt, die Benutzerfreundlichkeit zu verbessern. Darauf gehen wir als Nächstes ein und geben einen Überblick über Drumloop AI.

Schaffung von Schnittstellen für Open-Source-KI-Modelle

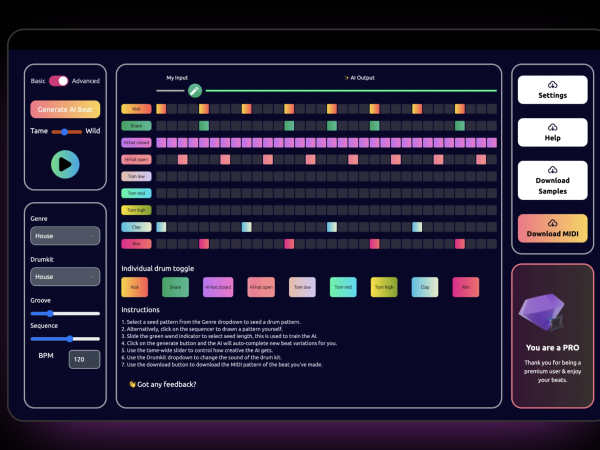

Magenta und MuseNet waren beide brauchbare Modelle, aber ihre Entwickler haben am wenigsten Zeit auf die Benutzeroberfläche verwendet. Also habe ich diesen Mehrspur-Sequenzer DrumloopAI auf der Grundlage des Magenta-DrumRNN-Modells gebaut, aber mit einer Web-App-Schnittstelle, die man auch ohne DAW nutzen kann.

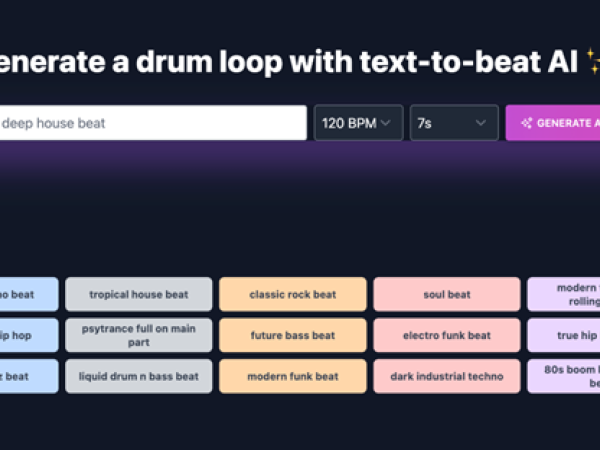

Die erste Version von DrumloopAI basierte auf Open-Source-KI-Audiomodellen wie AudioLM und verwendete Text-to-Beat-Workflows zur Steuerung des Systems. Die geringe Audiokompatibilität und die minimalen Steuerelemente veranlassten mich jedoch, MIDI und Audio-Sampling als zweite Schicht der App zu erforschen.

Heute haben wir sowohl AI-Audio- als auch AI-MIDI-Modelle in einem einzigen Produkt zusammengefasst, das sich an Beatmaker und Künstler der elektronischen Musik richtet.

Der Benutzer hat die Kontrolle über die BPM, den Musikstil, das Schlagzeug und die KI-Parameter (dargestellt durch die Schieberegler für Groove, Sequenz und "Wildness"). Jedes Mal, wenn der Benutzer einen Beat erzeugt, erscheint eine neue KI-generierte Sequenz. Stellen Sie sich das wie eine automatische Vervollständigung vor: Sie geben den ersten Beat vor und die KI schreibt die Fortsetzung dieses Beats und entwickelt ihn weiter. Dies ist ideal, um einen Jam zu starten oder neue Ideen zu erforschen.

Modelle wie Magenta und Musenet speichern keine Aufzeichnungen über frühere Sitzungen, daher haben wir eine Benutzerbibliothek für die Verwaltung dieser Projektdateien entwickelt. Dies führt zu einer besseren Gesamterfahrung, da großartige Ideen selten in der allerersten Sitzung fertiggestellt werden.

Heute haben wir sowohl einen Sequenzer als auch eine Text-to-Beat-Schnittstelle für Benutzer, die lieber mit einer textbasierten AI-Schnittstelle arbeiten. Hier steuern Sie die Ausgabe mit Ihrem Textprompt und können das gewünschte Tempo und die Schleifenlänge einstellen.

Ihr eigenes Unternehmen für Musiksoftware gründen

Im Internet gibt es heute eine wachsende Zahl von Open-Source-KI-Musik- und Audiomodellen. Wenn Sie darüber nachdenken, Ihr eigenes Unternehmen für Musiksoftware zu gründen, kann ich Ihnen hier einige einfache Tipps für den Einstieg geben.

Entscheiden Sie zunächst, ob Sie eine abonnementbasierte Webanwendung oder ein DAW-Plugin verwenden möchten. Dies sind sehr unterschiedliche Wege, die jeweils ihre Vor- und Nachteile haben. Als Plugin-Anbieter verwenden Sie C++ mit einem Softwareentwicklungs-Framework namens JUCE, während Webentwickler, die keine C++-Kenntnisse haben, mit einem Abonnementdienst besser zurechtkommen.

Als langjähriger Softwareentwickler und Agenturgründer falle ich persönlich in die zweite Kategorie. Bei einem SaaS-Geschäftsmodell ist viel mehr Wartung erforderlich, aber die Vorteile sind auch groß. Sie können Kunden gewinnen und Ihr Produkt schnell weiterentwickeln.

Bei einem Webdienst liegt der Schwerpunkt weniger auf der Kompatibilität mit dem Betriebssystem und mehr auf der Zugänglichkeit des Browsers (insbesondere bei der Musikwiedergabe mit älteren Browsern wie Safari).

Wenn Sie den webbasierten Weg wählen, können Sie schneller starten und ein größeres Publikum erreichen. Wenn Sie den Plugin-Weg wählen, sind Sie näher an den Produzenten, die in der DAW leben. Beides ist machbar, es kommt auf Ihr Produkt an.

Mein Hintergrund in SEO und Marketing hat mir bei der Markteinführung des Produkts ebenfalls sehr geholfen. Ein Produkt zu bauen ist nur die halbe Miete – die Leute dazu zu bringen, es zu benutzen, ist eine ganz andere Sache. Das würde den Rahmen dieses Artikels sprengen, aber ich kann dieses kurze Tutorial von meinen Freunden bei Dotted empfehlen, einer Agentur, die sich auf Werbung für Musik-Tech-Startups spezialisiert hat.

Wenn Sie Fragen zur Gründung Ihres eigenen Musikunternehmens haben, wenden Sie sich bitte direkt an unser Support-Portal unter DrumloopAI. Viel Spaß beim Hacken!

Nick Berns

Nick Berns ist der Gründer von Bluelightweb.co.nz, einer Performance-Marketing-Agentur mit einem starken Fokus auf SEO und Anzeigen. Er ist auch der Gründer von Bernssoftware.com, einem SaaS-Produktstudio, das innovative Unternehmen wie DrumloopAI.com, HairstyleAI.com und TattoosAI.com aufbaut und erwirbt.

Artikelthemen

Artikelübersetzungen erfolgen maschinell und redigiert.

Nick Berns

Nick Berns